SIGGRAPH 2023技术论文研究展示了进一步推进角色动画领域的创新

自50年前成立以来,SIGGRAPH一直是不断发展的计算机图形学和交互技术领域的创新思想和创新研究的中心。这些创新给我们带来了逼真的CGI,或电脑生成的图像,帮助传统的电影制作和游戏进入了一个新时代。

今年,世界各地的计算机科学家、艺术家、开发人员和行业专家于8月6日至10日在洛杉矶召开SIGGRAPH 2023会议。会议主席Erik Brunvand指出,今年SIGGRAPH的主题是将2023年定为“SIGGRAPH时代”,以纪念行业、社区和组织的完整年表——过去、现在和遥远的未来。

SIGGRAPH-Learning物理规则

CGI创新的一个例子是角色动画的不断发展。许多这些进步都是由动作捕捉技术推动的,这种技术始终如一地提供高效、最先进的视觉效果,在我们心爱的超级英雄大片中很常见。

人物动画研究领域的创造潜力是无穷无尽的。

“角色动画代表了计算机图形学中一个真正独特的领域。角色动画的目标是复制生物的智能和行为,这不仅适用于人类和动物,也适用于想象中的生物,”北京大学助理教授刘立斌说,他将和他的团队一起展示新的研究成果,作为SIGGRAPH 2023技术论文项目的一部分。

刘说:“多年来,研究界已经探索了许多实现这一目标的方法……随着我们在人工智能方面看到的令人兴奋的进展,利用大型语言模型或更全面的多模态模型作为角色的‘大脑’的研究将会蓬勃发展,再加上新的动作表示和生成框架的发展,将大脑的‘思想’转化为现实的行动。”“对于这个领域的所有人来说,这是一个激动人心的时刻。”

作为热门技术论文计划的预览,这里是三种独特方法的焦点,展示了进一步推进角色动画领域的创新。

肢体语言

我们中的许多人会无意识地用肢体语言交流或表达自己。我们中的一些人在说话时可能会用手做手势,改变身体姿势来表达观点,或者在身体的另一个部位(眼睛或腿)做出动作。事实上,语言和交流与肢体动作密切相关——这是一个复杂的数字序列。

来自中国北京大学和通用人工智能国家重点实验室的一组研究人员引入了一个复杂的计算框架,可以捕捉人类肢体语言手势的细微差别。这个框架允许用户使用广泛的输入数据来控制这些细节,包括一段文字描述,一个简短的演示片段,甚至是代表动物姿态的数据,比如一只鸟拍打或展开翅膀的视频。

支撑该团队新系统的关键组件是一种新的运动表示,特别是量化潜在运动嵌入,再加上扩散模型——这是最近人工智能驱动的图像生成技术背后的关键组件之一。这种表现方式大大减少了歧义,并确保了运动的自然和多样性。此外,他们还增强了OpenAI开发的CLIP模型,使其能够以多种形式解释风格描述,并开发了一种高效的句子分析技术,使数字角色能够理解语音的语义并确定最佳的手势时间。

在数字人类领域取得的进步的基础上,这项新工作解决了制造数字角色的挑战,这些数字角色能够在对话中做出肢体动作,并且只需要很少的指导或指令。该系统支持短文本、动作序列或视频剪辑形式的样式提示,并提供特定于身体部位的样式控制;例如,将瑜伽姿势(战士式)与感觉“快乐”或“悲伤”的手势结合起来。

“有了这项工作,我们离让数字人类像现实生活中的人一样又近了一步。该研究的主要作者、北京大学智能科技学院助理教授刘说:“我们的系统使这些虚拟角色能够在对话中表现出自然和多样化的手势,从而大大增强了互动的真实感和沉浸感。”

“也许这项技术最令人兴奋的方面是它能够让用户通过语言和演示直观地控制角色的动作。这也使系统能够与ChatGPT等先进的人工智能无缝对接,为我们的数字角色带来更高水平的智能和逼真度。”

刘和他的合作者,来自北京大学的奥腾龙和张泽毅,在SIGGRAPH 2023上展示了他们的新作品。在他们的项目页面上查看团队的论文和附带的视频。

运动中的逼真机器人

谁不喜欢跳舞的机器人呢?但是,如何轻松地复制或模拟有腿机器人及其动态运动仍然是角色动画领域的一个挑战。在一项新的研究中,来自迪士尼研究工程和苏黎世联邦理工学院的一个国际研究小组描述了一种创新技术,可以将富有表现力的物理运动最佳地重新定位到自由行走的机器人上。

从动作捕捉数据或其他数字艺术创作来源重新定位动作或编辑现有动作,是在数字世界中模拟物理动作的一种更快的方法。考虑到运动数据的比例、质量分布和自由度的显著差异,将它们编辑到不同的系统中是最具挑战性的。

为此,这项新技术可以将捕捉到的或艺术家提供的动作重新定位到比例和质量分布截然不同的有腿机器人上。

研究人员指出:“我们可以输入一个动作,然后自动求解出机器人执行该动作的最佳方式。”他们的方法考虑了机器人动力学和机器人的驱动限制,这意味着即使是高度动态的运动也可以成功地重新定位。结果是,机器人可以在不失去平衡的情况下完成运动——这不是一件容易的事。

后者是团队用这种新方法克服的主要障碍。由于动物或艺术家创建的钻机和有腿机器人之间的大小,形状存在显着差异,因此很难通过标准的最优控制技术和手动试错方法实现运动的重新定位。

研究人员的方法是一种可微分最优控制(DOC)技术,该技术允许他们求解一组全面的参数,使重定向不受比例、质量分布以及输入运动源与实际物理机器人之间的自由度数量差异的影响。

DOC背后的团队包括迪斯尼研究院的Ruben Grandia、Espen Knoop、Christian Schumacher和Moritz Bächer,以及ETH zrich的Farbod Farshidian和Marco Hutter。他们将作为SIGGRAPH 2023技术论文计划的一部分展示他们的工作。有关论文和视频,请访问该团队的项目页面。

网球,有人知道吗?

电脑游戏爱好者的终极梦想是能够在虚拟世界中控制他们的玩家,以一种反映玩家在现实世界中的运动能力和动作的方式。游戏的真实性才是最重要的。

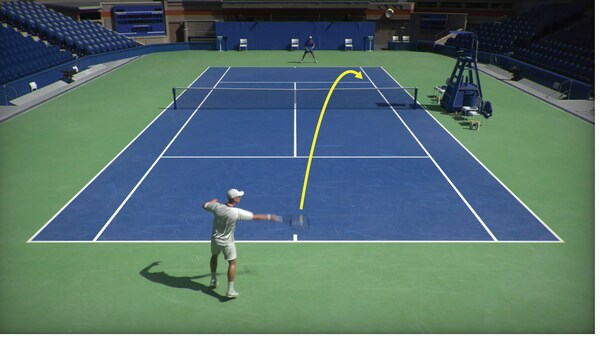

一个由计算机科学家组成的全球团队(其中一人也是网球专家和NCAA网球冠军)开发了一种基于物理的动画系统,该系统仅使用视频中的运动数据就可以产生多种复杂的网球比赛技巧。该团队的计算框架使两个模拟角色能够参与广泛的网球比赛,由从不同球员的比赛视频中学习到的控制器引导。

“我们的工作展示了利用互联网上丰富的体育视频来创造可以控制的虚拟人物的令人兴奋的可能性。这项新研究的第一作者、斯坦福大学计算机科学副教授凯冯·法塔利安(Kayvon Fatahalian)门下的博士生张浩天(音译)说:“它开启了一个未来,任何人都可以用自己的视频将虚拟人物带入生活。”张浩天和法塔利安在SIGGRAPH 2023上展示了他们的工作,以及来自NVIDIA,多伦多大学,矢量研究所和西蒙弗雷泽大学的合作者。

“想象一下,现在各种背景的人都可以负责动画制作,让他们的想法变得生动,这是多么令人难以置信的创造力和便利。”“潜力是无限的,现在每个人都可以轻松地实现虚拟角色的动画化。”

研究人员通过许多例子来展示这个系统,包括复制不同的球员风格,比如右手球员使用双手反手,反之亦然,以及捕捉不同的网球技巧,比如发球、正手上旋球和反手削球,等等。该系统可以通过模拟球拍和控球动态来产生两个物理模拟人物进行长时间的网球拉力赛。

除了张浩天和法塔利安, NVIDIA的合作者Ye Yuan, Viktor Makoviychuk和Yunrong Guo,多伦多大学的Sanja Fidler以及NVIDIA和西蒙弗雷泽大学的薛斌彭都在SIGGRAPH 2023上展示了他们的成果。完整的论文和视频,请访问该团队的页面。

每年,SIGGRAPH技术论文计划涵盖从动画,仿真和成像到几何,建模,人机交互,制造,机器人等研究领域。通过观看SIGGRAPH 2023技术论文预告片来了解今年的内容,并查看完整的程序以了解更多细节。访问SIGGRAPH 2023网站注册。

关于ACM、ACM SIGGRAPH和SIGGRAPH 2023

ACM(美国计算机协会)是世界上最大的教育和科学计算协会,它将教育工作者、研究人员和专业人士联合起来,激发对话,共享资源,并应对该领域的挑战。ACM SIGGRAPH是ACM内部的一个特殊兴趣小组,为计算机图形学和交互技术的研究、技术和应用方面的成员提供跨学科社区服务。SIGGRAPH会议是世界领先的年度跨学科教育经验,展示了最新的计算机图形学和交互技术。SIGGRAPH 2023是由ACM SIGGRAPH主办的第50届年会,将于8月6日至10日在洛杉矶会议中心现场举行,并提供虚拟访问选项。