NVIDIA推出用于大型语言模型和生成式AI工作负载的推理平台

谷歌云,D-ID,为广泛的生成式AI服务使用新平台,包括聊天机器人,文本到图像内容,AI视频等

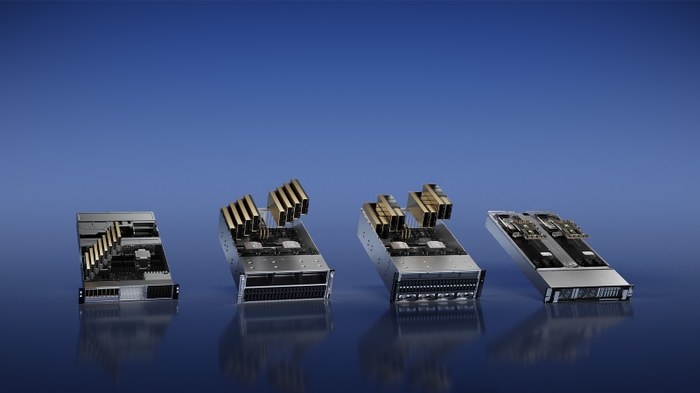

GTC-NVIDIA推出了四个推理平台,为一系列快速出现的生成式AI应用程序进行了优化,帮助开发人员快速构建专门的AI驱动应用程序,以提供新的服务和见解。

这些平台将NVIDIA的全栈推理软件与最新的NVIDIA Ada、NVIDIA Hopper™和NVIDIA Grace Hopper™处理器结合在一起,包括近日发布的NVIDIA L4 Tensor Core GPU和NVIDIA H100 NVL GPU。每个平台都针对需求工作负载进行了优化,包括AI视频、图像生成、大型语言模型部署和推荐推理。

NVIDIA创始人兼首席执行官黄仁勋表示:“生成式人工智能的兴起需要更强大的推理计算平台。生成式人工智能的应用数量是无限的,只受人类想象力的限制。为开发人员配备最强大、最灵活的推理计算平台,将加速新服务的创建,以目前无法想象的方式改善我们的生活。”

加速生成式AI的多样化推理工作负载集

每个平台都包含一个针对特定生成式AI推理工作负载优化的NVIDIA GPU以及专门的软件:

用于AI视频的NVIDIA L4可以提供比cpu高出120倍的AI视频性能,同时能源效率提高99%。作为几乎任何工作负载的通用GPU,它提供了增强的视频解码和转码功能、视频流、增强现实、生成式AI视频等。

NVIDIA L40用于图像生成,针对图形和支持ai的2D、视频和3D图像生成进行了优化。L40平台作为NVIDIA Omniverse™的引擎,Omniverse™是一个用于在数据中心构建和操作元宇宙应用程序的平台,与上一代相比,提供了7倍的稳定扩散推理性能和12倍的Omniverse性能。

NVIDIA H100 NVL用于大型语言模型部署,是大规模部署ChatGPT等大型llm的理想选择。在数据中心规模上,与上一代A100相比,具有94GB内存和Transformer Engine加速的新H100 NVL在GPT-3上提供了高达12倍的推理性能。

NVIDIA Grace Hopper推荐模型是图推荐模型,向量数据库和图神经网络的理想选择。CPU和GPU之间的900 GB/s NVLink®-C2C连接,与PCIe Gen 5相比,Grace Hopper可以提供7倍快的数据传输和查询。

平台的软件层以NVIDIA AI企业软件套件为特点,其中包括用于高性能深度学习推理的软件开发工具包NVIDIA TensorRT™,以及有助于标准化模型部署的开源推理服务软件NVIDIA Triton inference Server™。

早期采用和支持

谷歌Cloud是NVIDIA推理平台的重要云合作伙伴和早期客户。它正在将L4平台集成到其机器学习平台Vertex AI中,并且是第一个提供L4实例的云服务提供商,其G2虚拟机的私人预览于今天发布。

最早在谷歌Cloud上使用L4的两家机构包括:Descript,它使用生成式人工智能帮助创作者制作视频和播客,WOMBO,它提供一款名为Dream的人工智能文本数字艺术应用程序。

另一个早期采用者,快手提供了一个内容社区和社交平台,利用gpu来解码传入的直播视频,捕捉关键帧,优化音频和视频。然后,它使用基于变压器的大规模模型来理解多模式内容,并提高全球数亿用户的点击率。

快手高级副总裁余岳表示:“快手推荐系统服务于一个每天有超过3.6亿用户的社区,这些用户每天贡献数百万个UGC视频。与相同总拥有成本的cpu相比,NVIDIA gpu将系统端到端吞吐量提高了11倍,并将延迟降低了20%。”

D-ID是领先的生成式人工智能技术平台,通过使用NVIDIA L40 gpu从文本中生成逼真的数字人类,为专业人士提升视频内容,为任何内容提供面部,同时降低了大规模视频制作的成本和麻烦。

“L40的表现简直令人惊叹。有了它,我们能够将推断速度提高一倍,”D-ID研发副总裁Or Gorodissky说。“D-ID很高兴使用这种新硬件作为我们产品的一部分,它能够以前所未有的性能和分辨率实现人工智能人类的实时流,同时降低我们的计算成本。”

Seyhan Lee是一家领先的人工智能制作工作室,使用生成式人工智能为电影、广播和娱乐行业开发沉浸式体验和迷人的创意内容。

Seyhan Lee联合创始人皮纳尔•德米达格(Pinar Demirdag)表示:“L40 GPU为我们的生成式人工智能应用程序带来了令人难以置信的性能提升。凭借L40的推理能力和内存大小,我们可以部署最先进的模型,以难以置信的速度和准确性为客户提供创新服务。”

Cohere是语言人工智能领域的领先先驱,运营着一个平台,允许开发人员构建自然语言模型,同时保持数据的私密性和安全性。

Cohere首席执行官Aidan Gomez表示:“NVIDIA全新的高性能H100推理平台可以使我们通过最先进的生成模型为客户提供更好、更高效的服务,为各种NLP应用提供支持,如对话式人工智能、多语言企业搜索和信息提取。”

可用性

NVIDIA L4 GPU已在谷歌云平台上提供私人预览,也可从超过30家计算机制造商的全球网络中获得,包括研华、华硕、Atos、思科、戴尔科技、富士通、GIGABYTE、惠普企业、联想、QCT和超微。

NVIDIA L40 GPU目前可从领先的系统制造商那里获得,包括华硕、戴尔科技、技嘉、惠普企业、联想和超微,合作伙伴平台的数量将在全年扩大。

Grace Hopper超级芯片目前正在取样,预计在今年下半年全面投产。H100 NVL GPU预计也将在今年下半年推出。

NVIDIA AI企业版现在可在主要云市场以及数十个系统供应商和合作伙伴处购买。通过NVIDIA AI企业版,客户可以获得NVIDIA企业版支持、定期安全审查以及NVIDIA Triton Inference Server、TensorRT和50多个预训练模型和框架的API稳定性。

可在NVIDIA LaunchPad上免费试用用于生成式AI的NVIDIA推理平台的动手实验室。示例实验室包括培训和部署支持聊天机器人,部署端到端AI工作负载,在H100上调优和部署语言模型,以及使用NVIDIA Triton™部署欺诈检测模型。