顶级推理性能的实现

使用NVIDIA H100 Tensor Core GPU和NVIDIA TensorRT-LLM实现顶级推理性能

一流的人工智能性能需要高效的并行计算架构、高效的工具栈和深度优化的算法。NVIDIA发布了开源的NVIDIA TensorRT-LLM,其中包括NVIDIA H100张量核心GPU核心的NVIDIA Hopper架构的最新内核优化。这些优化使Llama 270b等模型能够在H100 gpu上使用加速的FP8操作执行,同时保持推理精度。

在最近的发布会上,AMD谈到了与MI300X芯片相比,H100 GPU的推理性能。共享的结果没有使用优化的软件,如果经过适当的基准测试,H100的速度要快2倍。

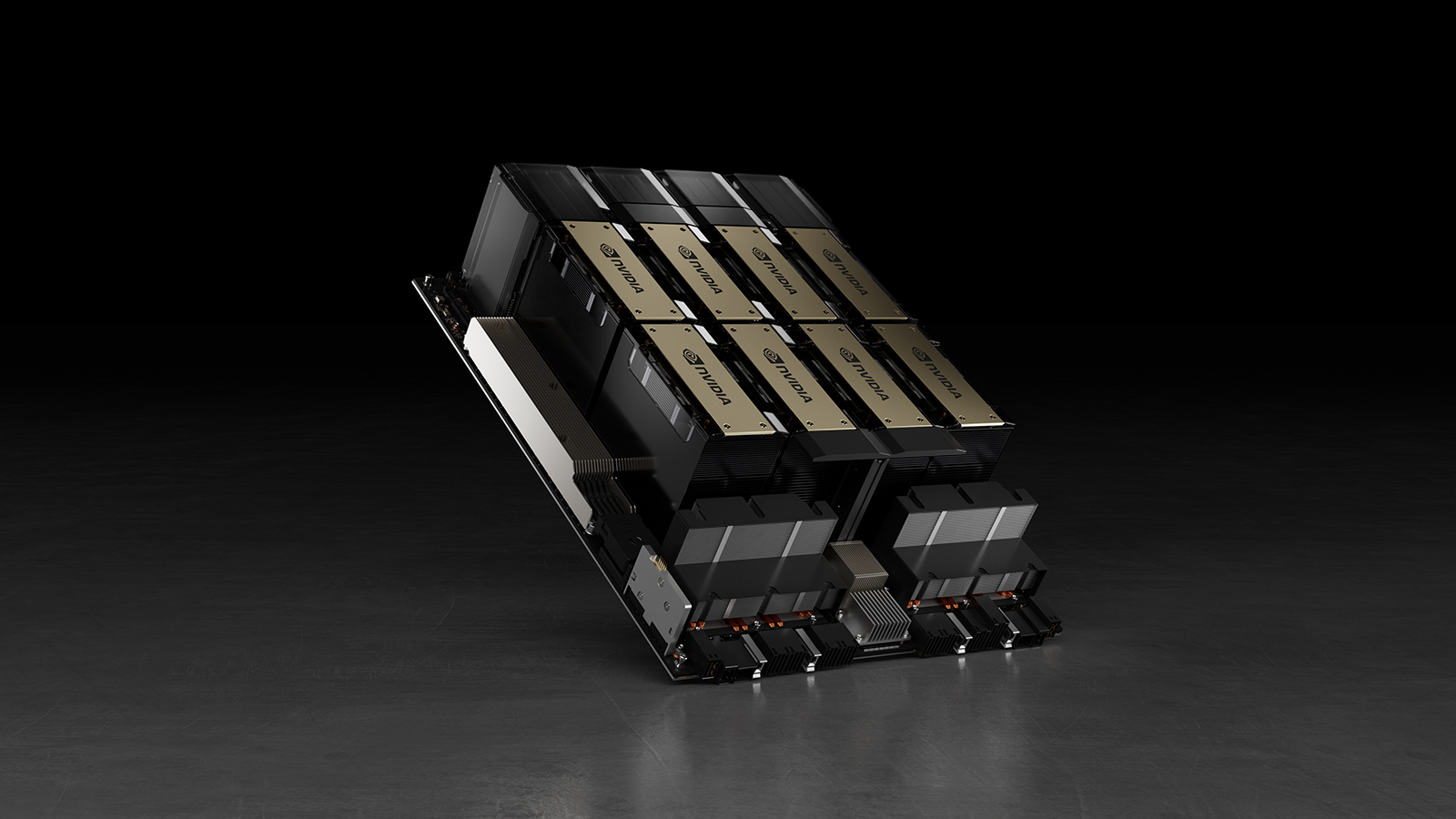

以下是在Llama 270b型号上使用8个NVIDIA H100 gpu的单个NVIDIA DGX H100服务器的实际测量性能。这包括一次处理一个推理请求的“Batch-1”的结果,以及使用固定响应时间处理的结果。

Llama 270b服务器在查询中的推理性能图表

图1所示。Llama 270b服务器的推理性能(每秒查询数),“Batch 1”的2048个输入令牌和128个输出令牌,以及各种固定的响应时间设置

AMD对H100的隐含权利要求是根据AMD发布演示脚注#MI300-38中的配置进行测量的。使用vLLM v.02.2.2推理软件与NVIDIA DGX H100系统,Llama 2 70B查询,输入序列长度为2048,输出序列长度为128。他们声称相对性能与DGX H100与8倍GPU MI300X系统相比。

对于NVIDIA测量数据,DGX H100具有8倍NVIDIA H100张量核心gpu,具有80 GB HBM3,具有公开可用的NVIDIA TensorRT-LLM,第1批v0.5.0和延迟阈值测量v0.6.1。工作负载细节与脚注#MI300-38相同。

DGX H100可以在1.7秒内处理单个推理,批量大小为1,换句话说,一次处理一个推理请求。批处理大小为1的结果是为模型提供最快的响应时间。为了优化响应时间和数据中心吞吐量,云服务为特定服务设置了固定的响应时间。这使他们能够将多个推理请求组合成更大的“批”,并增加服务器每秒的总体推理。像MLPerf这样的行业标准基准也使用这个固定的响应时间度量来度量性能。

响应时间上的小权衡可能会导致服务器可以实时处理的推理请求数量的x因子。使用固定的2.5秒响应时间预算,一台8-GPU DGX H100服务器每秒可以处理5个以上的Llama 270b推理,而第一批服务器每秒处理不到一个。

人工智能正在快速发展,NVIDIA CUDA生态系统使我们能够快速持续地优化我们的堆栈。我们期待着通过每次软件更新继续提高AI性能,因此请务必查看我们的性能页面和GitHub网站以获取最新信息。