頂級推理性能的實現

使用NVIDIA H100 Tensor Core GPU和NVIDIA TensorRT-LLM實現頂級推理性能

壹流的人工智能性能需要高效的並行計算架構、高效的工具棧和深度優化的算法。NVIDIA發布了開源的NVIDIA TensorRT-LLM,其中包括NVIDIA H100張量核心GPU核心的NVIDIA Hopper架構的最新內核優化。這些優化使Llama 270b等模型能夠在H100 gpu上使用加速的FP8操作執行,同時保持推理精度。

在最近的發布會上,AMD談到了與MI300X芯片相比,H100 GPU的推理性能。共享的結果沒有使用優化的軟件,如果經過適當的基準測試,H100的速度要快2倍。

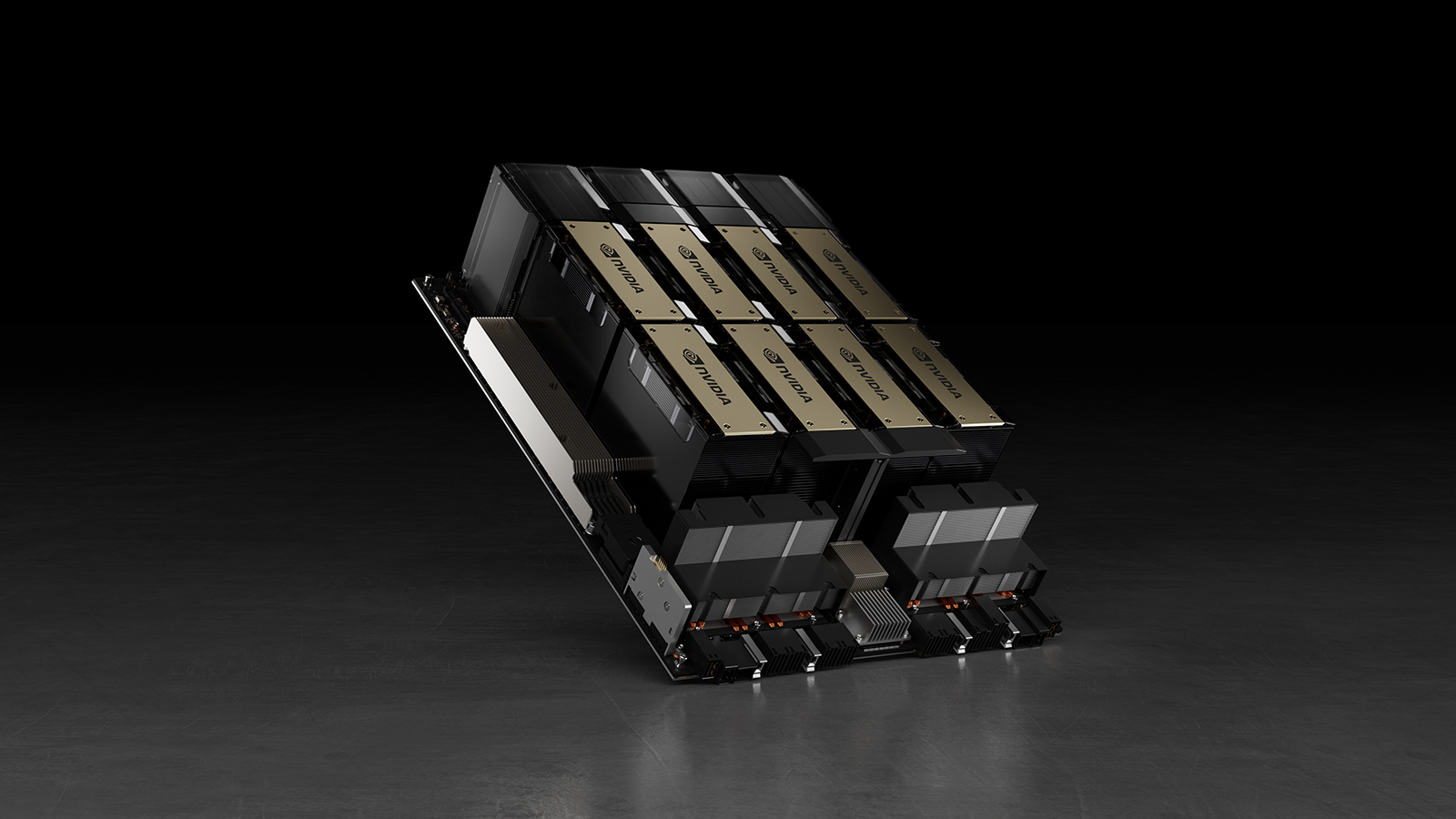

以下是在Llama 270b型號上使用8個NVIDIA H100 gpu的單個NVIDIA DGX H100服務器的實際測量性能。這包括壹次處理壹個推理請求的“Batch-1”的結果,以及使用固定響應時間處理的結果。

Llama 270b服務器在查詢中的推理性能圖表

圖1所示。Llama 270b服務器的推理性能(每秒查詢數),“Batch 1”的2048個輸入令牌和128個輸出令牌,以及各種固定的響應時間設置

AMD對H100的隱含權利要求是根據AMD發布演示腳註#MI300-38中的配置進行測量的。使用vLLM v.02.2.2推理軟件與NVIDIA DGX H100系統,Llama 2 70B查詢,輸入序列長度為2048,輸出序列長度為128。他們聲稱相對性能與DGX H100與8倍GPU MI300X系統相比。

對於NVIDIA測量數據,DGX H100具有8倍NVIDIA H100張量核心gpu,具有80 GB HBM3,具有公開可用的NVIDIA TensorRT-LLM,第1批v0.5.0和延遲閾值測量v0.6.1。工作負載細節與腳註#MI300-38相同。

DGX H100可以在1.7秒內處理單個推理,批量大小為1,換句話說,壹次處理壹個推理請求。批處理大小為1的結果是為模型提供最快的響應時間。為了優化響應時間和數據中心吞吐量,雲服務為特定服務設置了固定的響應時間。這使他們能夠將多個推理請求組合成更大的“批”,並增加服務器每秒的總體推理。像MLPerf這樣的行業標準基準也使用這個固定的響應時間度量來度量性能。

響應時間上的小權衡可能會導致服務器可以實時處理的推理請求數量的x因子。使用固定的2.5秒響應時間預算,壹臺8-GPU DGX H100服務器每秒可以處理5個以上的Llama 270b推理,而第壹批服務器每秒處理不到壹個。

人工智能正在快速發展,NVIDIA CUDA生態系統使我們能夠快速持續地優化我們的堆棧。我們期待著通過每次軟件更新繼續提高AI性能,因此請務必查看我們的性能頁面和GitHub網站以獲取最新信息。