使用新的NVIDIA Triton和NVIDIA TensorRT功能增强您的AI推理

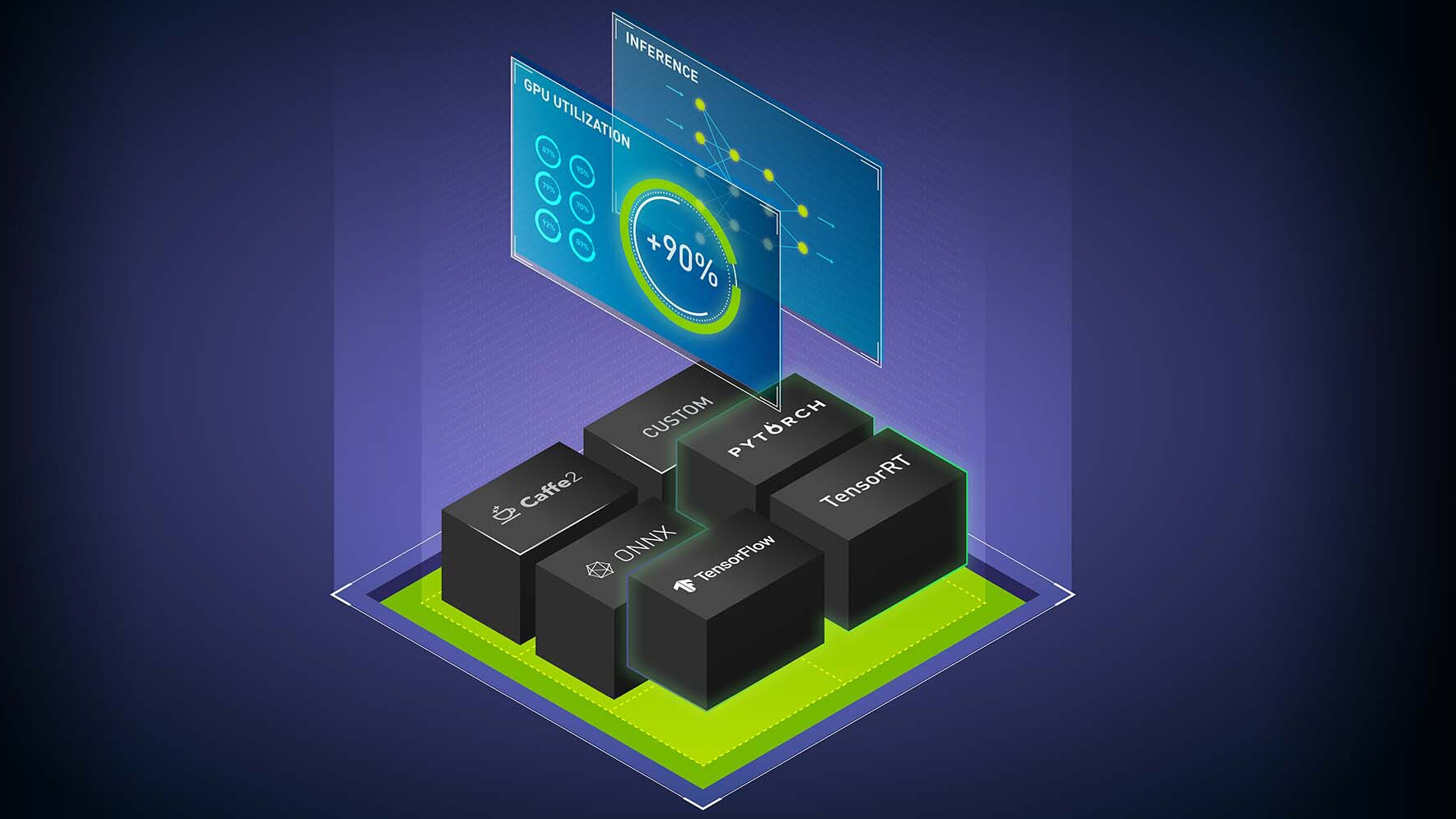

NVIDIA AI推理软件由NVIDIA Triton推理服务器(开源推理服务软件)和NVIDIA TensorRT(用于高性能深度学习推理的SDK,包括深度学习推理优化器和运行时)组成。它们为所有人工智能深度学习用例提供加速推理。NVIDIA Triton还支持传统的机器学习(ML)模型和cpu推理。这篇文章解释了该软件最近添加的主要新功能。

NVIDIA Triton的新功能包括PyTriton的本地Python支持,模型分析器更新和NVIDIA Triton管理服务。

PyTriton的原生Python支持

PyTriton特性提供了一个简单的接口,可以在Python代码中使用NVIDIA Triton Inference Server。PyTriton使Python开发人员能够使用NVIDIA Triton来服务从AI模型或简单处理函数到整个推理流程的所有内容。

Python中对NVIDIA Triton的本机支持使机器学习模型的快速原型和测试具有性能,效率和高硬件利用率。一行代码就可以启动NVIDIA Triton,提供诸如动态批处理、并发模型执行以及从Python代码中支持gpu和cpu等好处。这种方法消除了建立模型存储库和转换模型格式的需要。您可以使用现有的推理流程代码而无需修改。要尝试它,请访问GitHub上的triton-inference-server/pytriton。

模型分析

模型分析器是一种工具,可帮助找到最佳的NVIDIA Triton模型配置(如批处理大小、模型并发性和精度),以部署有效的推理。由于新的快速搜索模式,您可以在几分钟内获得最佳配置,而无需花费数天时间手动试验配置参数。

现在,除了支持具有预处理和后处理需求的现代推理工作负载的独立模型之外,模型分析器还支持模型集成(也称为模型流程)和多模型分析。您可以为整个ML流程运行模型分析器。有关更多信息,请参阅模型分析器文档。

NVIDIA Triton管理服务

NVIDIA Triton Management Service为高效的多模型推理提供模型编排功能。该功能作为生产服务运行,根据需要加载模型,在不使用时卸载模型。

它通过在单个GPU服务器上放置尽可能多的模型来有效地分配GPU资源,并有助于优化来自不同框架的模型,以实现高效的内存使用。它现在支持基于推断和加密(AES-256)与应用程序通信的高利用率的NVIDIA Triton实例的自动缩放。申请提前使用NVIDIA Triton管理服务。

英伟达TensorRT

TensorRT的新特性包括多gpu多节点推理、性能和硬件优化等。

多gpu多节点推理

TensorRT可以用于运行大型语言模型(llm)的多gpu多节点推理。它支持GPT-3 175B, 530B和6.7B型号。这些模型不需要ONNX转换;相反,一个简单的Python API可用于优化多gpu推理。现在可以在私人抢先体验中使用。请联系您的NVIDIA客户团队了解更多详情。

TensorRT 8.6

TensorRT 8.6现在可以在早期访问,包括以下主要功能:

生成式AI扩散和变压器模型的性能优化

在不同GPU架构(NVIDIA Ampere架构及更高版本)上构建和运行的硬件兼容性

版本兼容性,可以在不同的TensorRT版本(TensorRT 8.6及更高版本)上构建和运行

在构建时间和推理性能之间进行交易的优化级别

客户和合作伙伴亮点

了解以下新客户和合作伙伴如何使用NVIDIA Triton和TensorRT进行AI推理。

Oracle AI使用NVIDIA Triton在OCI Vision中提供基于深度学习的图像分析工作负载。视觉服务用于各种用例,从制造缺陷检查到在线图像中的标记项目。Oracle使用NVIDIA Triton实现了50%的低延迟和2倍的吞吐量。

Uber利用NVIDIA Triton为该公司基于深度学习的全球ETA模型DeepETA每秒提供数十万次预测。

在线体验平台Roblox使用NVIDIA Triton在多个框架中运行所有人工智能模型,以实现游戏推荐、构建虚拟角色、内容审核、市场广告和欺诈检测等用例。NVIDIA Triton让数据科学家和机器学习工程师可以自由选择他们的框架:TensorFlow、PyTorch、ONNX或原始Python代码。

DocuSign使用NVIDIA Triton运行NLP和计算机视觉模型,用于人工智能辅助审查和理解协议和合同条款。与之前基于cpu的解决方案相比,该公司实现了10倍的加速。

描述使用TensorRT优化模型来加速人工智能推理。它允许用户替换他们的视频背景,增强他们的演讲,以产生工作室质量的内容,而不需要工作室。

CoreWeave是一家专业的GPU云提供商,使用NVIDIA Triton为llm提供低延迟和高吞吐量的服务。

NVIDIA推理软件提供了在云端、数据中心、网络边缘和嵌入式设备中为下一代AI产品和服务提供动力的关键性能、效率和响应能力。从今天开始使用NVIDIA Triton和TensorRT。

作者:Shankar Chandrasekaran/ nvidia