量子计算机可能率先应用于人工智能

作为电子计算机发展到今天的最前沿应用,人工智能始终存在算力不足的隐忧。ChatGPT问世数月后,OpenAI总裁奥尔特曼曾公开表示,其并未鼓励更多用户注册OpenAI。2023年11月,OpenAI甚至宣布暂停ChatGPT Plus付费订阅新用户的注册,以确保现有用户拥有高质量体验。显然,作为全球性能最强的AI,ChatGPT已遇到算力等方面的瓶颈。在此背景下,讨论量子计算机在人工智能领域的应用就成为一种颇具潜力的未来解决方案。

首先,人工智能领域的算法,大部分属于并行计算的范畴。举例而言,AlphaGo在下围棋的过程中,其需要同时考虑对手在不同位置落子后的应对招数,从中找到最有可能赢得棋局的下法。这就需要计算机优化并行计算的效率来实现。而量子计算机擅长进行并行计算,因为它可以同时计算和存储“0”和“1”两种状态,无需像电子计算机那样消耗额外的计算资源,譬如串联多个计算单元,或将计算任务在时间上并列。计算任务越复杂,量子计算就越具备优势。

其次,运行ChatGPT所需的硬件条件,同样也十分适合导入当前体积庞大的量子计算机,二者都需要安装在高度集成的计算中心里,由一支专业化技术团队进行管理支撑。

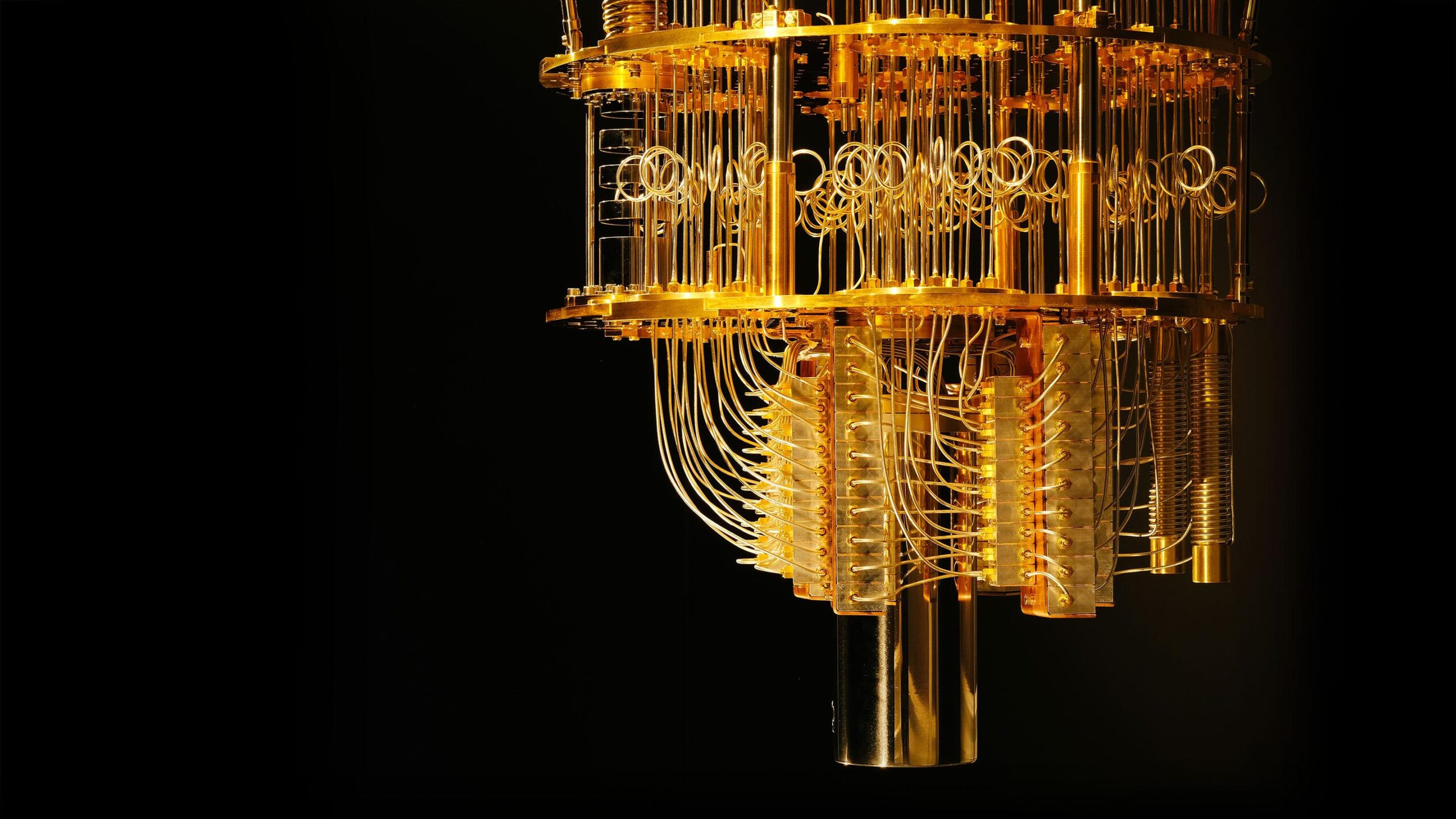

什么是量子计算机?量子计算机是一类遵循量子力学规律进行高速数学和逻辑运算、存储及处理量子信息的物理装置。其不仅体积庞大,而且作为核心零部件的“量子芯片”,通常需要被置于接近绝对零度(零下273.15摄氏度)的极低温中,利用在这种极低温下部分微观粒子表现出的量子特性进行信息运算和处理,且运行结果只能存在几毫秒的时间。

量子计算机的原理基于量子力学,利用量子比特代替传统计算机的比特进行信息处理。与经典比特只能处于0或1的状态不同,量子比特可以同时处于多种状态,这一特性被称为“叠加态”。此外,量子比特之间还存在着“纠缠”现象,使得它们之间的状态相互依赖,无论距离多远都能瞬间影响彼此,这就是著名的“量子纠缠”。这些量子特性赋予了量子计算机超越传统计算机的强大潜力。在理论上,量子计算机能够在某些特定问题上实现指数级别的加速,如因子分解、搜索优化、材料科学模拟等。

2022年,来自谷歌、微软、加州理工学院等机构的研究者从原理上证明了“量子优势”在预测可观测变量、量子主成分分析以及量子机器学习中确实存在。量子机器学习,实际上就是量子计算在人工智能领域的应用,也体现出未来量子计算与人工智能两大前沿技术合流的趋势。

理论上证明了,实践上就需要进一步拓展量子计算的应用前景。在2019年推出商用量子计算机“量子系统一号”后,美量子计算巨头IBM又于2023年12月推出了“量子系统二号”。新系统的最大突破在于可以模块化扩展,是该公司的首台模块化量子计算机。“量子系统二号”拥有超过1000量子位。IBM还宣布计划10年内建成10万量子位的量子计算机。这些不断增加的量子位并非只是为了竞赛,其对于实现通用计算和可编程有着不可或缺的作用。也正因如此,量子计算机的模块化,标志着其更加具备实用性。

有关量子机器学习算法的研究,已成为新的研究热点。量子计算机的突破不仅是科学技术的重大进展,也是人类探索未知、提升计算能力的重要里程碑。不过,未来量子计算机不会完全取代电子计算机,更有可能出现的是量子计算机和电子计算机在不同的应用场景下发挥各自所长,实现协同发展,既极大提升算力,也兼顾成本和可行性。