英伟达推出下一代GH200 Grace Hopper超级芯片平台

英伟达推出下一代GH200 Grace Hopper超级芯片平台,面向加速计算和生成式人工智能时代

全球首款HBM3e处理器提供突破性内存和带宽;能够连接多个gpu的卓越性能;易于扩展的服务器设计

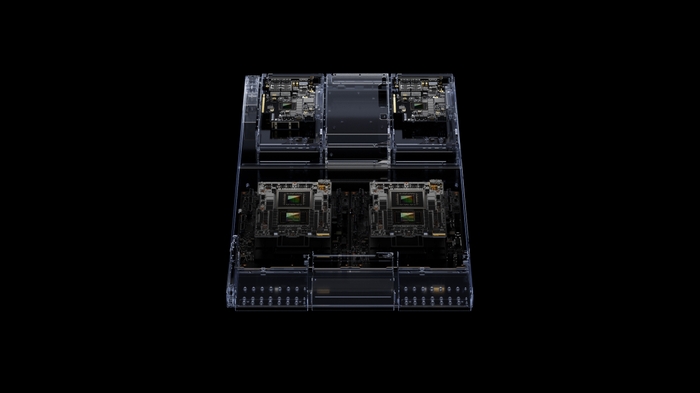

NVIDIA宣布推出下一代NVIDIA GH200 Grace Hopper™平台,该平台基于搭载全球首款HBM3e处理器的新型Grace Hopper超级芯片,专为加速计算和生成式人工智能时代而打造。

新平台旨在处理世界上最复杂的生成式人工智能工作负载,涵盖大型语言模型、推荐系统和矢量数据库,可用于各种配置。

双配置——提供比当前一代产品多3.5倍的内存容量和3倍的带宽——包括一台带有144个Arm Neoverse内核的服务器,每秒8千万亿次的人工智能性能和282GB的最新HBM3e内存技术。

英伟达创始人兼首席执行官黄仁勋表示:“为了满足对生成式人工智能不断增长的需求,数据中心需要满足特殊需求的加速计算平台。新的GH200 Grace Hopper超级芯片平台提供了卓越的内存技术和带宽,以提高吞吐量,将gpu连接到聚合性能而不妥协的能力,以及可以轻松部署在整个数据中心的服务器设计。”

新平台使用Grace Hopper超级芯片,该芯片可与NVIDIA NVLink™的其他超级芯片连接,使它们能够协同工作,部署用于生成式人工智能的巨型模型。这种高速、连贯的技术使GPU能够完全访问CPU内存,在双配置时提供1.2TB的快速内存。

HBM3e内存比目前的HBM3快50%,提供总计10TB/秒的综合带宽,使新平台能够运行比以前版本大3.5倍的模型,同时提高性能,内存带宽提高3倍。

对Grace Hopper的需求不断增长

领先的制造商已经提供基于先前宣布的Grace Hopper超级芯片的系统。为了推动这项技术的广泛采用,下一代具有HBM3e的Grace Hopper超级芯片平台与今年早些时候在COMPUTEX上公布的NVIDIA MGX™服务器规范完全兼容。使用MGX,任何系统制造商都可以快速且经济高效地将Grace Hopper添加到100多个服务器变体中。

可用性

领先的系统制造商预计将在2024年第二季度交付基于该平台的系统。