NVIDIA宣布Hopper架构,下一代加速计算

作为全球人工智能基础设施的新引擎,NVIDIA H100 GPU实现了数量级的性能飞跃

gtc -为了推动下一波人工智能数据中心的发展,英伟达近日宣布了其采用NVIDIA Hopper™架构的下一代加速计算平台,该平台的性能比其前身有了一个量级的飞跃。

以美国计算机科学家先驱格雷斯•霍珀(Grace Hopper)的名字命名的新架构接替了两年前推出的英伟达(NVIDIA)安培架构。

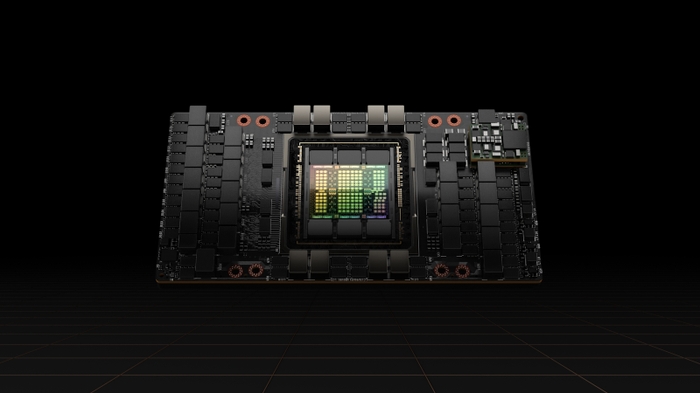

该公司还发布了首款基于hopper的GPU NVIDIA H100,配备了800亿个晶体管。H100是世界上最大、最强大的加速器,具有突破性的功能,如革命性的Transformer引擎和高度可扩展的NVIDIA NVLink®互连,用于推进巨大的人工智能语言模型、深度推荐系统、基因组学和复杂的数字双胞胎。

英伟达创始人兼首席执行官黄延森表示:“数据中心正在成为人工智能工厂——处理和提炼堆积如山的数据以产生智能。”“NVIDIA H100是全球AI基础设施的引擎,企业利用它来加速AI驱动的业务。”

H100技术突破

NVIDIA H100 GPU在加速大规模人工智能和高性能计算方面树立了新标准,提供了6项突破性创新:

- 世界上最先进的芯片——由800亿个晶体管组成,采用先进的台积电4N处理器,用于NVIDIA的加速计算需求。H100在加速人工智能、高性能计算、内存带宽、互连和通信方面具有重大进展,包括近5tb / s的外部连接。H100是第一个支持PCIe Gen5的GPU,也是第一个使用HBM3的GPU,内存带宽可达3TB/s。20个H100 gpu可以支持相当于整个世界的互联网流量,使客户能够交付先进的推荐系统和大型语言模型,对数据进行实时推理。

- 新的Transformer引擎——现在是自然语言处理的标准模型,Transformer是迄今为止发明的最重要的深度学习模型之一。与上一代相比,H100加速器的Transformer引擎可将这些网络的速度提高6倍,同时不降低精度。

- 第二代安全多实例GPU——MIG技术允许单个GPU被划分为七个更小的、完全隔离的实例,以处理不同类型的任务。Hopper架构通过在云环境中跨每个GPU实例提供安全的多租户配置,将MIG的能力比上一代扩展了7倍。

- 机密计算——H100是世界上第一个具有机密计算能力的加速器,可以在处理人工智能模型和客户数据时保护它们。客户还可以将机密计算应用于对隐私敏感的行业(如医疗保健和金融服务)的联合学习,以及共享云基础设施。

第四代NVIDIA NVLink——为了加速最大的AI模型,NVLink结合了一个新的外部NVLink Switch,将NVLink扩展为服务器以外的扩展网络,与上一代使用NVIDIA HDR Quantum InfiniBand相比,以更高的9倍带宽连接最多256 H100 gpu。

DPX指令——新的DPX指令可加速动态编程——可用于多种算法,包括路由优化和基因组学——与cpu相比可提高40倍,与上一代gpu相比可提高7倍。这包括在动态仓库环境中为自主机器人舰队寻找最佳路线的Floyd-Warshall算法,以及用于DNA和蛋白质分类和折叠的序列比对的Smith-Waterman算法。

H100结合的技术创新扩展了英伟达的人工智能推理和培训领导能力,以实现使用大规模人工智能模型的实时和沉浸式应用。H100将使聊天机器人使用世界上最强大的单片变压器语言模型,威震天530B,具有比上一代高30倍的吞吐量,同时满足实时对话AI所需的亚秒延迟。H100还允许研究人员和开发人员训练大型模型,如具有3950亿个参数的Mixture of Experts,速度快9倍,将训练时间从几周缩短到几天。

广泛采用NVIDIA H100

NVIDIA H100可以部署在任何类型的数据中心,包括内置、云、混合云和边缘。预计今年晚些时候,全球领先的云服务提供商和电脑制造商以及英伟达(NVIDIA)将直接提供这一服务。

NVIDIA的第四代DGX™系统DGX H100,拥有8个H100 gpu,以新的FP8精度提供32千万亿次的AI性能,提供的规模,以满足大型语言模型、推荐系统、医疗保健研究和气候科学的大规模计算需求。

DGX H100系统的每个GPU都通过第四代NVLink连接,提供900GB/s的连通性,比上一代多1.5倍。NVSwitch™使所有8个H100 gpu通过NVLink连接。在下一代NVIDIA DGX SuperPOD™超级计算机中,一个外部NVLink Switch可以连接多达32个DGX H100节点。

Hopper获得了业界领先的云服务提供商阿里巴巴云、亚马逊网络服务、百度AI云、谷歌云、微软Azure、甲骨文云、腾讯云等计划提供基于h100的实例的广泛支持。

全球领先的系统制造商,包括源讯、BOXX科技、思科、戴尔科技、富士通、GIGABYTE、H3C、惠普企业、浪潮、联想、Nettrix和Supermicro等,预计将推出一系列配备H100加速器的服务器。

NVIDIA H100的每个级别

H100将以SXM和PCIe形式出现,以支持广泛的服务器设计需求。还将提供融合加速器,将H100 GPU与NVIDIA ConnectX®-7 400Gb/s InfiniBand和以太网SmartNIC配对。

NVIDIA的H100 SXM将在HGX™H100服务器板上提供4路和8路配置,适用于应用程序可扩展到一个服务器中的多个gpu或跨多个服务器的企业。基于HGX h100的服务器为AI训练和推理以及数据分析和HPC应用提供最高的应用性能。

H100 PCIe支持2个gpu NVLink连接,带宽达到PCIe 5.0的7倍以上,在主流企业服务器上的应用中具有卓越的性能。它的形状因素使得它很容易集成到现有的数据中心基础设施中。

H100 CNX是一款新型融合加速器,将H100与ConnectX-7 SmartNIC结合在一起,为企业数据中心的多节点人工智能培训和5G信号处理等I/ o密集型应用提供突破性的性能。

基于NVIDIA Hopper架构的GPU也可以与NVIDIA Grace™CPU配对,具有超快的NVLink-C2C互连,CPU和GPU之间的通信速度比PCIe 5.0快7倍以上。这一组合——Grace Hopper超级芯片——是一个集成模块,旨在服务于大规模的高性能计算和人工智能应用。

英伟达软件支持

NVIDIA H100 GPU由强大的软件工具支持,使开发者和企业能够构建和加速从人工智能到高性能计算的应用程序。这包括对NVIDIA用于语音、推荐系统和超尺度推理等工作负载的AI软件套件的重大更新。

NVIDIA还发布了超过60项CUDA-X™库、工具和技术的更新,以加速量子计算和6G研究、网络安全、基因组学和药物发现方面的工作。

可用性

NVIDIA H100将从第三季度开始上市。

欲了解更多关于NVIDIA Hopper和H100的信息,请观看黄仁勋的GTC 2022主题演讲,并免费注册GTC 2022,参加与NVIDIA和行业领袖的会议。